Selbst der glühendste Fan des Disney-Klassikers „Das Dschungelbuch“ aus dem Jahr 1967 muss zugeben, dass die Neuauflage von 2016 die bekannte Zeichentrickgeschichte hervorragend in eine Realverfilmung übertragen konnte. Im Jahr 2019 plant Disney, den Trick zu wiederholen, indem es die Geschichte des König der Löwen in einem lebendigen, atmenden Pride Lands nacherzählt, voller Pflanzen, Tiere und Bäume, die so real sind, dass man sie fast berühren könnte.

Außer, dass weder der Dschungel noch das Geweihte Land, egal wie „real“ sie aussehen, überhaupt real sind. Die Blätter, die Bäume, die Wasserfälle – im Dschungelbuch sind alle außer dem jungen Menschenjungen Mowgli digitale Erscheinungen, die mit der hochmodernen Filmmagie visueller Effekte heraufbeschworen werden.

Wenn man über Filmeffekte nachdenkt, denken die meisten Menschen an den Begriff Spezialeffekte. Unter Spezialeffekten versteht man jedoch Dinge, die am Set während der Dreharbeiten physisch ausgeführt werden, wenn Schauspieler mit animatronischen Puppen, Miniaturmodellen oder echten Explosionen interagieren.

Visuelle Effekte hingegen sind Effekte, die auf den Film angewendet werden, nachdem er gedreht wurde. In der Vergangenheit haben wir Ray Harryhausens Stop-Motion-Puppen genossen; Im digitalen Zeitalter erstellt spezielle Animationssoftware erstaunlich lebensechte computergenerierte (CG) Charaktere wie Caesar in Planet der Affen, Thanos in Avengers: Infinity War und die digital erstellten Tierabgüsse aus dem Dschungelbuch und dem König der Löwen.

Auch außerhalb des Fantasy-Genres sind visuelle Effekte ein großer Teil des Filmgeschäfts. „Der Prozess, einen Film zu machen, ist mittlerweile eng mit visuellen Effekten verflochten“, sagt Adam Valdez, der für „Das Dschungelbuch“ im Auftrag seines Teams vom Effekthaus Moving Picture Company (MPC) einen Oscar für visuelle Effekte entgegennahm. „Überraschenderweise beginnen sogar Dramen und Komödien viel mit visuellen Effekten zu arbeiten.“

Moderne Blockbuster sind mit so vielen visuellen Effekten gefüllt, dass jede Produktion die Arbeit normalerweise auf mehrere Unternehmen verteilt, wie MPC, Industrial Light and Magic, Weta, Framestore und Digital Domain, um nur einige zu nennen. Um zu sehen, wie diese Unternehmen Effekte zaubern und kombinieren, besuchte ich die Londoner MPC-Studios, um Valdez und Richard Stammers, einen weiteren Supervisor für visuelle Effekte, zu treffen und die Animatoren zu treffen, die digitale Löwen, Tiger und Bären zum Leben erwecken, während Softwareentwickler proprietäre Apps entwickeln, um sie genau nachzuahmen das Chaos und die Trümmer von Explosionen, Flutwellen und Raumschiffen, die in Wolkenkratzer krachen. rich-magazine-vfx-bts-21

Grünes Licht: Vorproduktion

Die Arbeit für jeden Film beginnt mit der Vorproduktion. „Langweiligerweise beginnen wir mit Geld“, sagt Valdez. „Die Kosten dafür sind sehr hoch. Es sind viele Menschen beteiligt und viel Computerleistung, daher braucht man eine gute Planung und eine gute Struktur, um die verrückte Frist einzuhalten.“

In Studios auf der ganzen Welt verfügt MPC über 18 verschiedene Abteilungen digitaler Experten, die virtuelle Umgebungen erstellen, die Anatomie von Tieren erforschen, um Charaktere von innen nach außen zu animieren und digitale Elemente mit realem Filmmaterial kombinieren, um ein fotorealistisches Endbild zu erstellen. Ein einzelner Film kann mehrere Jahre lang Hunderte von Menschen beschäftigen, um die fertigen Aufnahmen zu produzieren, aber selbst eine kleinere Szene kann monatelange Arbeit und Dutzende von Künstlern erfordern. MPC arbeitete ein Jahr lang daran, eine einzige Figur für Blade Runner 2049 zu erschaffen: Rachael, die weniger als 90 Sekunden auf dem Bildschirm zu sehen war.

Laut Valdez variieren die Lösungen je nach Produktion, die Filmemacher als „Show“ bezeichnen.

„Jede Show scheint uns mit kleinen Überraschungen und neuen Ideen zu bewerfen, und wir müssen unsere Tools und unsere Methodik an das jeweilige Projekt anpassen“, sagt er. „Es ist nie wirklich Fließbandarbeit.“

Überlegungen zu visuellen Effekten fließen zunehmend in die Gestaltung selbst der physischen Sets des Films und in die Art und Weise ein, wie die Schauspieler gefilmt werden. In einer Szene im Dschungelbuch geht Mowgli an einem knorrigen Ast eines Baumes entlang und spricht dabei mit dem Panther Bagheera. Auf der Greenscreen-Tonbühne baute und beleuchtete das Team ein lindgrünes Styropormodell des Zweigs, an dem der Schauspieler entlanggehen konnte. Seine Bewegungen, sein Blickkontakt mit Bagheera sowie die Lichter und Schatten mussten alle mit den sorgfältig geplanten digitalen Elementen übereinstimmen, die später in das resultierende Filmmaterial eingefügt wurden.

Es kann schwer sein, sich vorzustellen, wie ein Set funktionieren wird, wenn es nur im Computer vorhanden ist. Deshalb nutzen Filmemacher die neueste Virtual-Reality-Technologie, um in ihre virtuellen Orte vorzudringen. Steven Spielberg zum Beispiel setzte ein VR-Headset auf, um in die für „Ready Player One“ erstellten CG-Umgebungen einzutauchen und so die gewünschten Aufnahmen zu machen, als würde er auf einer echten Bühne herumlaufen.

Das Erstellen einer CG-Umgebung kann genauso viel kosten wie der Bau eines echten Sets, aber die eigentliche Arbeit besteht darin, einen digitalen Standort fotorealistisch aussehen zu lassen. „Wenn es real gebaut werden kann, dann bauen Sie es real“, sagt Stammers. „Weil es echt aussehen wird.“

Das Budget für visuelle Effekte ist besser für das Hervorzaubern von Dingen reserviert, die im wirklichen Leben nicht möglich sind. Aber das beschränkt sich nicht nur auf fantastische Erfindungen wie todesmutige Stunts, riesige Raumschiffe oder sprechende Tiger. Visuelle Effekte werden immer häufiger für prosaischere Zwecke eingesetzt, etwa um eine Szene zu erstellen, die in der Dämmerung spielt – was im wirklichen Leben schwer zu drehen ist, da man jeden Tag nur einen kurzen Teil der tatsächlichen Dämmerung sieht – und um anachronistische Züge eines historischen Films darzustellen Ort, wie Schilder und Antennen.

Bereit für die Nahaufnahme: Produktion

Sobald der Vorproduktionsplan steht, beginnt die Hauptfotografie. Hierbei handelt es sich um den traditionellen Filmdreh, bei dem die sprechenden Schauspieler beim Gehen auf realen Sets oder vor Greenscreen-Kulissen gefilmt werden. Dieses Originalmaterial ist der Ausgangspunkt für den Workflow des Teams für visuelle Effekte (VFX), der als Pipeline bezeichnet wird.

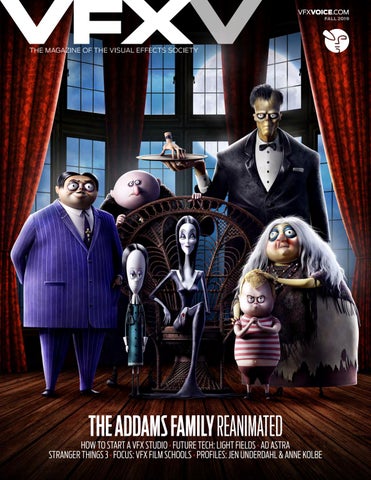

Die Visual-Effects-Supervisoren jedes Unternehmens begleiten den Regisseur, den Kameramann und den Rest der Crew am Set. Sie müssen bewerten, wie jede saubere, unveränderte Aufnahme – eine so genannte „Platte“ – mit den digital erstellten Elementen zusammenpasst, die später hinzugefügt werden.VFX Voice – Herbstausgabe 2019 der Visual Effects Society – Ausgabe

Auch das Sammeln von Referenzaufnahmen ist von entscheidender Bedeutung. Bei der Entwicklung einer digitalen Kreatur beispielsweise fotografiert das Team häufig eine Puppe, eine sogenannte Maquette, um zu sehen, wie sich die Beleuchtung über ihre Winkel und Oberflächen hinweg verhält. Außerdem fotografieren sie eine silberne Kugel, die in ihrer glänzenden Oberfläche das gesamte Set widerspiegelt, um die Position der Lichter aufzuzeichnen, und eine Chromkugel, um die Intensität der Lichter aufzuzeichnen.

Es ist entscheidend, dass selbst die kleinsten Details der digitalen Elemente mit dem echten Filmmaterial übereinstimmen. Um später Sets und Orte genau nachzubilden, scannt das VFX-Team die Räume auch mit verschiedenen Techniken, darunter lasergepulstes Lidar zur Entfernungsmessung und Photogrammetrie zur Kartierung des Raums anhand von Fotos, die aus verschiedenen Winkeln aufgenommen wurden. „Wir neigen dazu, alles um uns herum zu fotografieren, weil wir nie genau wissen, was wir nachbilden müssen“, sagt Valdez.

Weitere Techniken sind die digitale Set-Erweiterung, bei der ein VFX-Team ein kleines Set durch das Hinzufügen eines CG-Hintergrunds größer erscheinen lässt, und die Performance-Aufnahme, bei der ein Schauspieler ein hautenges, mit Tracking-Markern bedecktes Outfit anzieht, um die Rolle eines CG-Charakters darzustellen. Die VFX-Teams nutzen die Tracking-Marker als Referenzpunkte, um die Figur später über die Bewegungen des Schauspielers zu animieren.

Trotz aller Planung müssen die Schauspieler und der Regisseur am Set noch Raum haben, um verschiedene Dinge auszuprobieren, etwa Werbetexte zu schreiben oder ihre Darbietung anzupassen. Wichtig ist, dass technische Aspekte wie die Augenlinien der Schauspieler auch dann konsistent bleiben, wenn der kreative Prozess etwas locker verläuft. Es mag trivial klingen, aber solche kaum wahrnehmbaren Details sind entscheidend, um die Illusion fantastischer Bilder wie einer realen Person, die mit einem Tier spricht, zu verkaufen – und wenn diese Details nicht stimmen, bemerken die Betrachter schnell, dass etwas nicht stimmt, auch wenn sie es nicht bemerken Ich kann durchaus sagen, woran es liegen könnte.

Am Ende müssen die VFX-Teams die empfindliche Balance zwischen fotorealistischem und, nun ja, coolem Aussehen finden. „Sie wollen eine Explosion mit Charakter“, sagt Valdez. „Es ist nicht einfach, es realistisch aussehen zu lassen und gleichzeitig ästhetische Aspekte zu kontrollieren.“

Und Schnitt: Postproduktion

Selbst während die Dreharbeiten am Set stattfinden, erstellt die Armee der Animatoren bei MPC CG-Charaktere und -Umgebungen, sogenannte Assets.

Bei der Entwicklung eines digitalen Charakters baut das VFX-Team zunächst ein digitales Skelett mit realistisch beweglichen Gelenken auf, um sicherzustellen, dass sich der CG-Charakter überzeugend bewegt. Anschließend modellieren sie je nach Bedarf Muskel-, Haut- und Fell- oder Haarschichten. In jeder Phase wird eine Version mit niedriger Auflösung in Grundbewegungen wie Gehen und Laufen animiert, um schnell zu überprüfen, ob sie überzeugend aussieht. Diese ganze Arbeit kann Monate dauern, insbesondere für Charaktere, die viel Zeit auf der Leinwand haben werden. Besonders problematisch ist die Animation von Haaren oder Fell, da jede einzelne Haarsträhne ein Teil der Geometrie in der Software ist.

Nachdem die Dreharbeiten abgeschlossen sind, macht sich das VFX-Team an die Anpassung des Filmmaterials. Möglicherweise müssen sie Markierungen entfernen, Besatzungsmitglieder, die sich in Helmen und Fenstern spiegeln, ausmalen oder Details wie Flammen, Rauch oder Wildtiere hinzufügen.rich-magazine-vfx-bts-9

Eine der ersten Prioritäten der Postproduktion ist der Matchmove-Prozess, bei dem echte Kamerabewegungen für jede Aufnahme in den Computer kopiert werden. Das Ziel: Wenn die reale Kamera über die auf einem Greenscreen-Set stehenden Schauspieler schwenkt, gleicht die Matchmove-Software die Schwenkbewegung aus, indem sie auf die gleiche Weise über den digitalen Hintergrund fährt.

„Wenn die Kamera in der Hand gehalten wird und sich bewegt, müssen wir diese Bewegung kopieren“, sagt Stammers und wackelt mit der Hand, um eine umherstreifende Kamera nachzuahmen. „Es ist ein sehr unterschätzter, aber unglaublich wichtiger Teil des Prozesses.“

Zu den Dingen, die echt aussehen müssen, gehören Elemente wie Feuer, Rauch oder Staubwolken, die von speziellen Softwarealgorithmen erzeugt werden. Viele VFX-Unternehmen entwickeln ihre eigene Software, um diese Naturphänomene zu simulieren. Zu der von MPC entwickelten proprietären Software gehört Furtility, das Fell und Fasern simuliert; Kali, das Zerstörung und zerfallende Trümmer simuliert; und Alice, die riesige Menschenmengen zum Leben erweckt.

Wenn alle mit den Aufnahmen zufrieden sind, ist es an der Zeit, die endgültige hochauflösende Version zu erstellen, die wir auf dem Bildschirm sehen. Dieser als Rendering bezeichnete Prozess benötigt viel Zeit und Rechenleistung, um alle für Kinoleinwände erforderlichen Details hinzuzufügen. „Die Renderzeit ist teuer“, sagt Stammers. „Man muss ziemlich sparsam damit umgehen, wie und wann man es nutzt. Wir haben eine riesige Renderfarm – sie ermöglicht uns jede Nacht Tausende und Abertausende Renderstunden.“

Aufgrund des Zeit- und Kostenaufwands werden die Aufnahmen erst dann vollständig umgesetzt, wenn alles vom Regisseur absolut genehmigt wurde. Stammers weist auf die äußerst komplexen simulierten Wellen für Ridley Scotts ägyptisches Epos „Exodus: Götter und Könige“ hin, die mehrere Renderstufen durchlaufen mussten. „Von der Person, die die erste Simulation initiiert, bis zu dem endgültigen Rendering können drei bis fünf Tage vergehen“, erinnert er sich. „Man muss also darüber nachdenken: ‚Bin ich wirklich, wirklich sicher?‘“

Das ist ein Wrap

Der letzte Schritt in der Pipeline für visuelle Effekte ist die Kombination aller realen und digitalen Elemente, um die endgültige Aufnahme zu erstellen. Stammers vergleicht diesen entscheidenden letzten Prozess, der als Compositing bezeichnet wird, mit dem Zusammensetzen eines Puzzles. „Im Compositing kann man eine Aufnahme machen oder scheitern lassen“, sagt er.

Komponisten prüfen, ob die Beleuchtung einer Figur im Vordergrund wirklich mit dem Hintergrund übereinstimmt oder ob ihre CG-Elemente bis auf die Unvollkommenheiten des Kameraobjektivs genau mit dem realen Filmmaterial übereinstimmen. Passenderweise werden die Räume, in denen das Compositing-Team von MPC arbeitet, manchmal im düsteren Halbdunkel gehalten, damit sie die fertigen Aufnahmen so sehen können, wie das Publikum sie sehen wird.

Bei Effektfirmen wie MPC arbeiten nicht nur Künstler und Komponisten, die an Filmaufnahmen arbeiten. Das Unternehmen verfügt außerdem über ein Forschungs- und Entwicklungsteam, das maßgeschneiderte Software entwickelt, sowie über eine Schulungsakademie, in der junge Animatoren lernen, fotorealistische Effekte zu erstellen.

Am Ende der Pipeline befindet sich die große Leinwand. Dort, in Kinos und Kinos auf der ganzen Welt, werden Kinobesucher von der wahren Magie visueller Effekte fasziniert: ihrer Macht, das Unwirkliche realer denn je zu machen.